小编注意到,OpenAI在其官网发布了新的更新,包括更多可控制的API模型、函数调用功能、更长的上下文和更低的价格。以下是官网原文:

我们在今年早些时候发布了gpt-3.5-turbo和gpt-4,在短短的几个月内,我们看到了开发者在这些模型上建立的令人难以置信的应用。

今天,我们又推出了一些令人兴奋的更新:

聊天完成API的新函数调用能力

gpt-4和gpt-3.5-turbo的更新和更多的指导性版本

gpt-3.5-turbo的新的16k上下文版本(相对于标准的4k版本)。

我们最先进的嵌入模型的成本降低了75%。

gpt-3.5-turbo的输入token成本降低25%。

宣布gpt-3.5-turbo-0301和gpt-4-0314模型的淘汰时间表

所有这些模型都有我们在3月1日推出的同样的数据隐私和安全保证–客户拥有从他们的请求中产生的所有输出,他们的API数据将不会被用于训练。

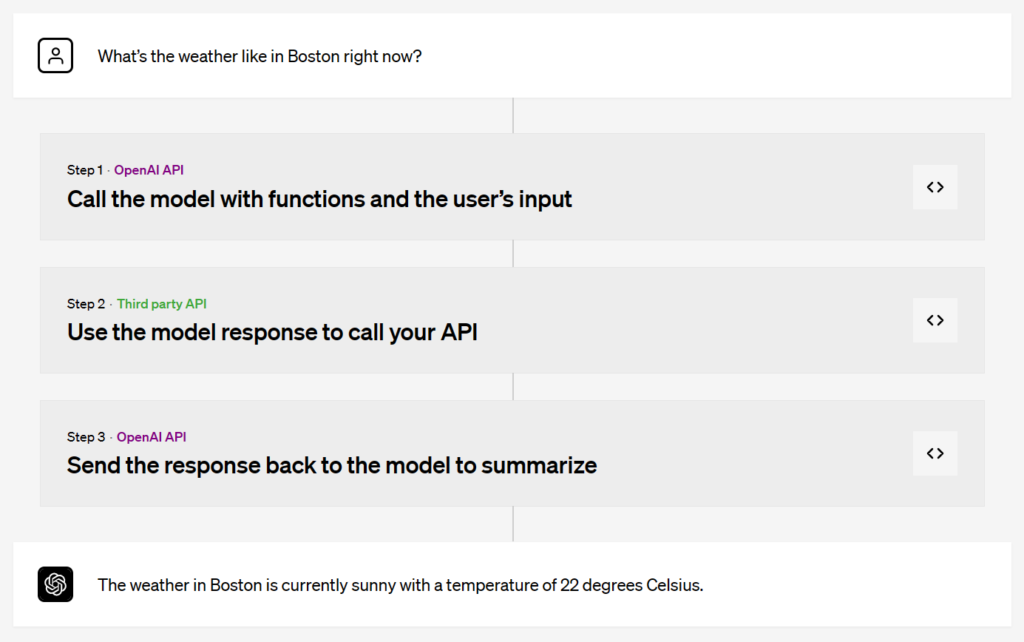

函数调用

开发者现在可以向gpt-4-0613和gpt-3.5-turbo-0613描述函数,并让模型智能地选择输出一个包含参数的JSON对象来调用这些函数。这是一种新的方式,可以更可靠地将GPT的能力与外部工具和API连接起来。

这些模型已经过微调,既可以检测到什么时候需要调用一个函数(取决于用户的输入),又可以用符合函数签名的JSON来响应。函数调用允许开发人员更可靠地从模型中获得结构化的数据。例如,开发人员可以:

创建聊天机器人,通过调用外部工具(例如,像ChatGPT插件)来回答问题

将诸如 “给Anya发邮件,看她下周五是否想喝咖啡 “这样的查询转换为send_email(to: string, body: string)这样的函数调用,或者将 “波士顿的天气如何?”转换为get_current_weather(location: string, unit: ‘celsius’ | ‘fahrenheit’)。

将自然语言转换为API调用或数据库查询

将 “谁是我这个月的十大客户?”转换为内部API调用,如get_customers_by_revenue(start_date: string, end_date: string, limit: int),或将 “Acme, Inc.上个月有多少订单?”转换成SQL查询,使用sql_query(query: string)。

从文本中提取结构化数据

定义一个名为extract_people_data(people: [{name: string, birthday: string, location: string}]的函数,以提取维基百科文章中提到的所有人物。

这些用例是由我们的/v1/chat/completions端点中的新API参数 functions 和 function_call促成的,它允许开发者通过JSON Schema向模型描述功能,并可选择要求它调用一个特定的功能。开始使用我们的开发者文档,如果你发现函数调用可以改进的情况,请添加evals。

函数调用示例

自从ChatGPT插件的alpha版本发布以来,我们已经学到了很多关于使工具和语言模型安全地一起工作的知识。然而,仍然有一些开放的研究问题。例如,一个概念验证的漏洞说明了来自工具输出的不受信任的数据如何能指示模型执行非预期的行动。我们正在努力减轻这些和其他风险。开发者可以通过以下方式来保护他们的应用程序:只从受信任的工具中获取信息,并在执行具有现实世界影响的行动之前加入用户确认步骤,如发送电子邮件、在网上发帖或进行购买。

新模型

GPT-4

gpt-4-0613包括一个带函数调用的更新和改进模型。

gpt-4-32k-0613包括与gpt-4-0613相同的改进,同时扩展了上下文长度,以便更好地理解大文本。

有了这些更新,我们将在未来几周内邀请更多等待名单上的人试用GPT-4,目的是通过这个模型完全取消等待名单。感谢所有耐心等待的人,我们很高兴看到你用GPT-4建造的东西!

GPT-3.5 Turbo

gpt-3.5-turbo-0613包括与GPT-4相同的功能调用,以及通过系统消息的更可靠的可引导性,这两个特性使开发者能够更有效地引导模型的响应。

gpt-3.5-turbo-16k以两倍的价格提供4倍于gpt-3.5-turbo的上下文长度:每1K输入token0.003美元,每1K输出token0.004美元。16k上下文意味着该模型现在可以在一次请求中支持约20页的文本。

模型的废弃

今天,我们将开始对3月份宣布的gpt-4和gpt-3.5-turbo的初始版本进行升级和废弃处理。使用稳定模型名称(gpt-3.5-turbo、gpt-4和gpt-4-32k)的应用程序将在6月27日自动升级到上面列出的新模型。为了比较不同版本的模型性能,我们的Evals库支持公共和私人的Evals,以显示模型的变化将如何影响你的用例。

需要更多时间过渡的开发者可以继续使用旧的模型,在他们的API请求的 “模型 “参数中指定gpt-3.5-turbo-0301、gpt-4-0314或gpt-4-32k-0314。这些旧型号将在9月13日之前可以访问,之后指定这些型号名称的请求将失败。你可以通过我们的模型弃用页面了解最新的模型弃用情况。这是这些模型的第一次更新;因此,我们热切地欢迎开发者的反馈,以帮助我们确保平稳过渡。

降低定价

我们继续使我们的系统更加有效,并将这些节省的费用回馈给开发者,从今天起生效。

Embeddings

text-embedding-ada-002是我们最受欢迎的嵌入模型。今天,我们将成本降低了75%,降至每1K token0.0001美元。

GPT-3.5 Turbo

gpt-3.5-turbo是我们最受欢迎的聊天模型,为数百万用户提供ChatGPT。今天,我们将gpt-3.5-turbo的输入token的成本降低了25%。开发人员现在可以使用这种模式,每1K输入token只需0.0015美元,每1K输出token只需0.002美元,这相当于1美元大约有700页。

gpt-3.5-turbo-16k的价格将为每1K输入token0.003美元,每1K输出token0.004美元。

开发者的反馈是我们平台发展的基石,我们将继续根据我们听到的建议做出改进。我们很高兴看到开发者如何在他们的应用程序中使用这些最新的模型和新功能。